Ratingen, Deutschland, 19. Juni 2023 — ASUS kündigte heute den ESC N8-E11 an, seinen fortschrittlichsten HGX H100 KI-Server mit acht GPUs, sowie ein umfassendes Portfolio an PCI Express® (PCIe®) GPU-Servern – die ESC8000- und ESC4000-Serien, die mit Intel®- und AMD®-Plattformen ausgestattet sind und höhere CPU- und GPU-TDPs unterstützen, um die Entwicklung von KI und Data Science zu beschleunigen.

ASUS ist einer der wenigen Anbieter von HPC-Lösungen mit eigenen, umfassenden Ressourcen, die aus der ASUS Server Business Unit, Taiwan Web Service (TWS) und ASUS Cloud bestehen – allesamt Teil der ASUS-Gruppe. Dies versetzt ASUS in die einzigartige Lage, internes KI-Serverdesign, Rechenzentrumsinfrastruktur und KI-Softwareentwicklungskapazitäten sowie ein vielfältiges Ökosystem von Partnerunternehmen für industrielle Hardware und Software anzubieten.

Fortschrittlicher, leistungsfähiger KI-Server senkt PUE-Wert im Rechenzentrum

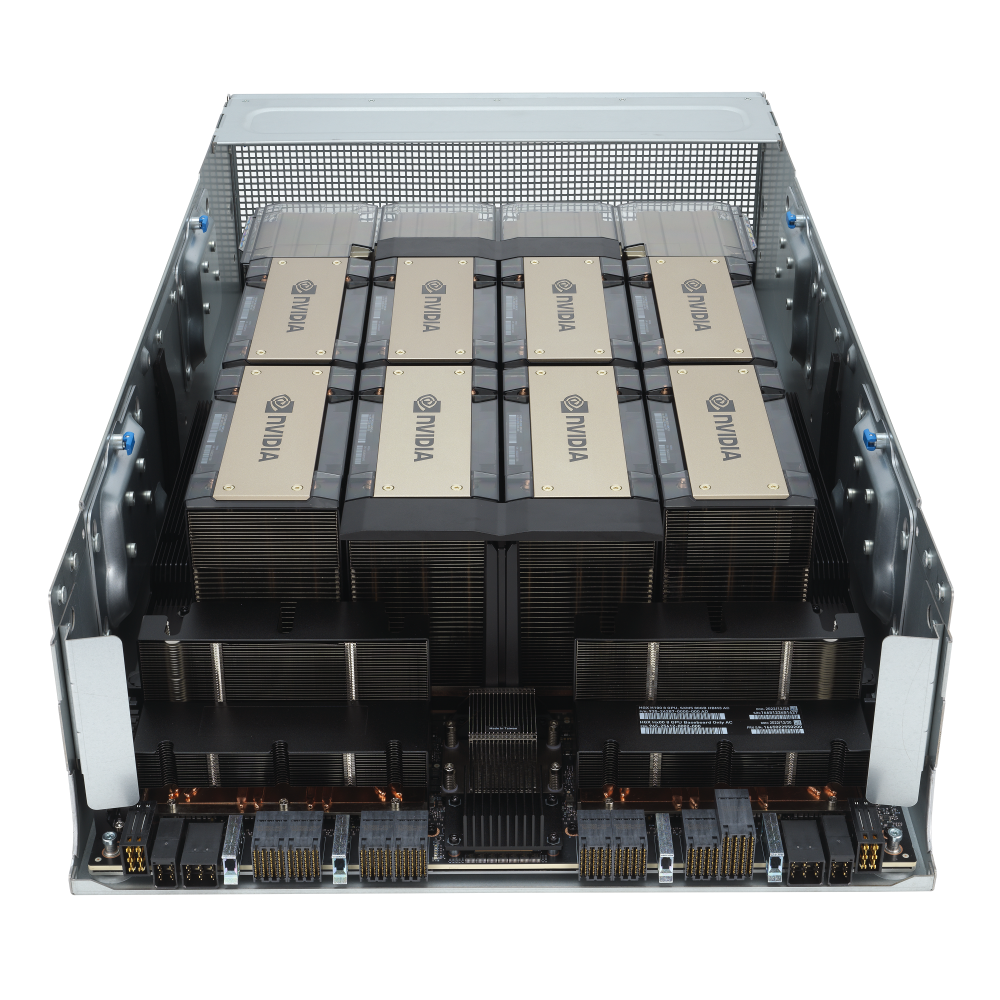

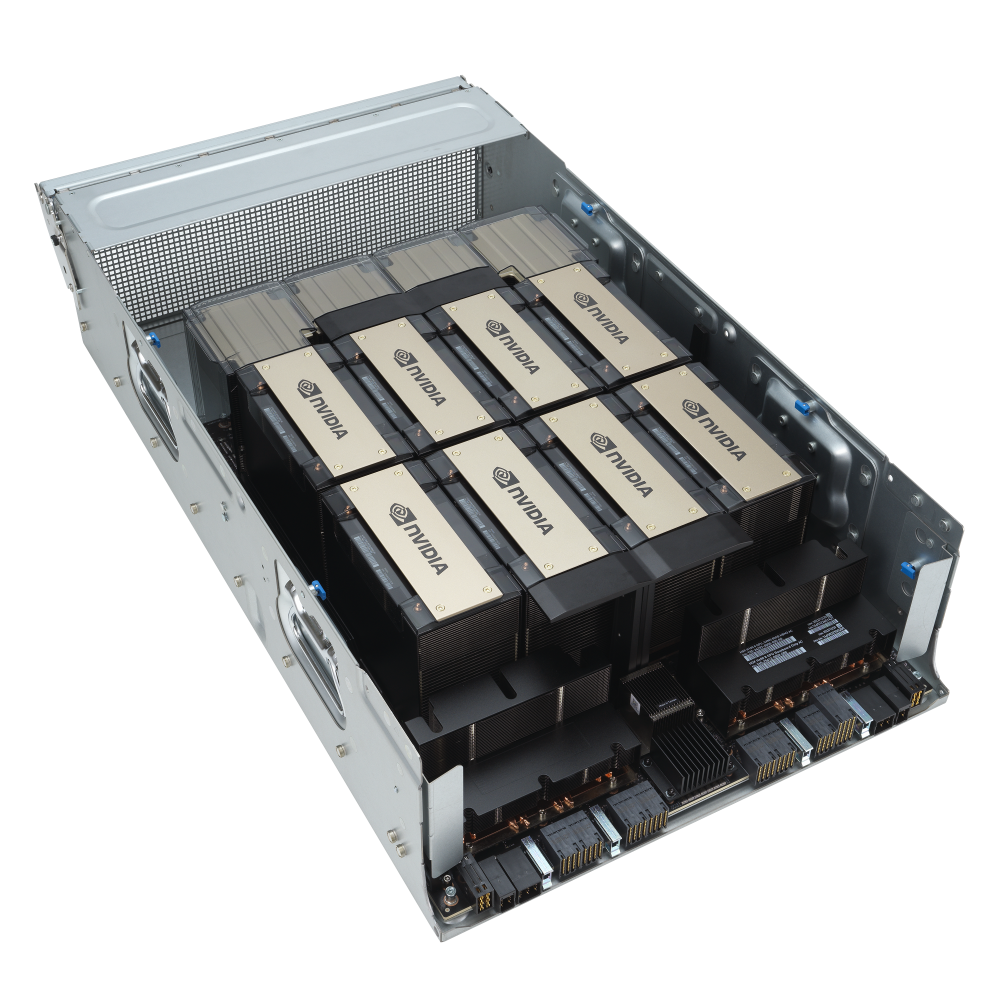

Der High-End ASUS ESC N8-E11 ist ein NVIDIA® HGX H100 KI-Server mit acht NVIDIA H100 Tensor Core GPUs und wurde entwickelt, um die benötigte Rechenzeit für groß angelegte KI-Trainingsmodelle und HPC zu reduzieren. Dieser 7U-Dual-Socket-Server mit Intel Xeon® Scalable Prozessoren der 4. Generation wurde speziell mit einer dedizierten 1-GPU-zu-1-NIC-Topologie entwickelt, die bis zu acht NICs unterstützt und den höchsten Durchsatz für rechenintensive Workloads bietet. Das modulare Design reduziert die Anzahl der verwendeten Kabel, was den Zeitaufwand für den Zusammenbau des Systems verringert, das Verlegen von Kabeln vermeidet und das Risiko einer Beeinträchtigung des Luftstroms senkt und somit eine thermische Optimierung gewährleistet.

Der ESC N8-E11 enthält NVLink und NVSwitch Technologie der vierten Generation sowie NVIDIA ConnectX-7 SmartNIC mit GPUDirect® RDMA und Storage mit NVIDIA Magnum IO™ und NVIDIA AI Enterprise, der Software-Schicht der NVIDIA AI Plattform, um die Entwicklung von KI und Data Science zu beschleunigen. Er wurde mit einem zweistufigen GPU- und CPU-Schlitten für thermische Effizienz, Skalierbarkeit und beispiellose Leistung entwickelt und ist für eine Direct-to-Chip-Flüssigkeitskühlung (D2C) vorbereitet, die die Gesamteffizienz des Stromverbrauchs (PUE “power-usage effectiveness”) eines Rechenzentrums stark verbessert.

PCIe-GPU-Server für alle Bereiche, von kleinen Unternehmen bis hin zu großen, Unified-KI-Trainingsclustern

Die ASUS NVIDIA-zertifizierte GPU-Server-Reihe umfasst Konfigurationen mit vier bis acht GPUs, die auf Intel- und AMD-Plattformen basieren. Ausgewählte Server sind für NVIDIA OVX optimiert, was bedeutet, dass sie bei Rendering- und Digital-Twin-Anwendungen hervorragende Leistungen erbringen.

Der ASUS ESC8000-E11 ist ein H100 PCIe-GPU-Server mit acht Steckplätzen, der für die Anforderungen von KI-Infrastrukturen in Unternehmen entwickelt wurde und mit branchenführenden GPUs, schnellerem GPU-Interconnect und höherer Fabric-Bandbreite eine noch nie dagewesene Leistung bietet. Er unterstützt bis zu acht GPUs mit NVIDIA NVLink Bridge und ermöglicht so eine Skalierung der Leistung und eine höhere Bandbreite, um wachsenden KI- und HPC-Workloads gerecht zu werden.

Spezifikationen

Weiter Informationen finden Sie auf der Produkteseite: https://servers.asus.com/products/servers/gpu-servers/ESC-N8-E11