In dieser Woche dreht sich in AI Decoded alles um die AI-Optimierungen, die NVIDIA TensorRT lokal auf den mehr als 100 Millionen RTX-Windows-PCs und -Workstations ausführt. Außerdem ist jetzt die neue Procyon AI Image Generation Benchmark von UL Solutions verfügbar und misst die reale Leistung von Hardware für die Erzeugung von AI-Bildern. Interne Tests zeigten Geschwindigkeitssteigerungen von 50 % auf einer GeForce RTX 4080 SUPER GPU im Vergleich zur schnellsten Nicht-TensorRT-Implementierung. GPU-Rezensenten können dies mit dem neuen UL Procyon Benchmark Reviewer’s Guide, der jetzt auf dem Presse-FTP von NVIDIA verfügbar ist, selbst testen.

Bevor es zu den Neuigkeiten geht, hier eine kurze Auffrischung:

=> Tensor Cores sind die dedizierten AI-Beschleuniger auf RTX-GPUs, die effizient lokale Hochleistungs-AI liefern.

=> NVIDIA TensorRT ist eine Reihe von Tools – d.h. ein Software Development Kit (SDK) – die es Entwicklern ermöglicht, auf die Hardware zuzugreifen, um vollständig optimierte AI-Erlebnisse zu schaffen.

=> NVIDIA TensorRT-LLM ist eine Open-Source-Bibliothek, die es LLMs ermöglicht, Anfragen schneller und effizienter zu verstehen und zu beantworten. ChatRTX basiert auf TensorRT-LLM für optimierte Leistung auf RTX-GPUs, und jeder kann mit TensorRT-LLM-optimierten Modellen in den NVIDIA AI Foundation-Modellen experimentieren.

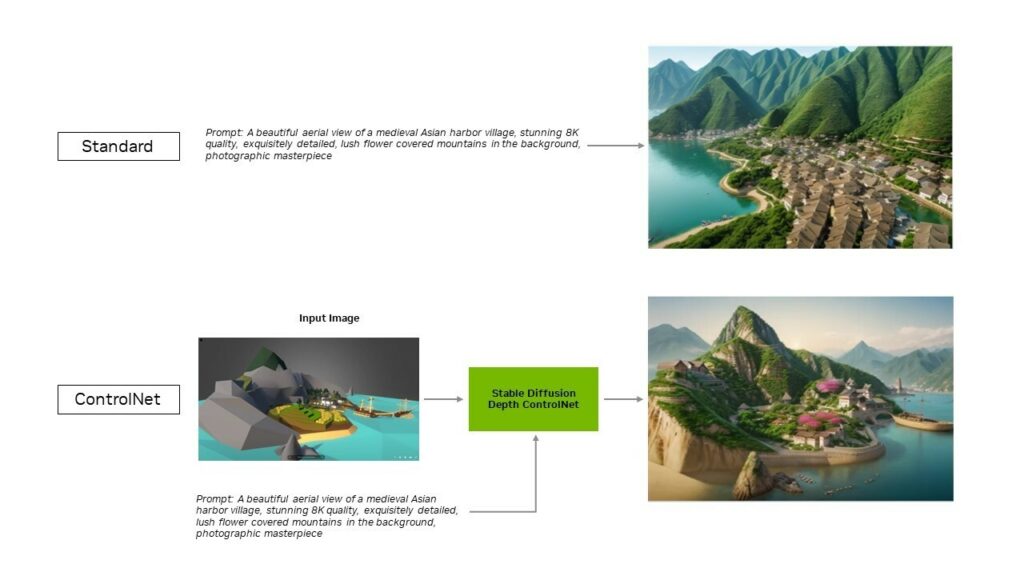

Für LLMs beschleunigt TensorRT einige der beliebtesten generativen AI-Modelle, einschließlich Stable Diffusion und SDXL. Neu in dieser Woche ist, dass die TensorRT-Optimierung, die die beliebte Stable Diffusion WebUI von Automatic 1111 beschleunigt, jetzt auch ControlNets unterstützt, eine Reihe von AI-Modellen, die wie spezielle Assistenten agieren, um den Nutzern mehr Kontrolle über ihre generierten Bilder zu geben – mit einer Steigerung von bis zu 40 %. Die Erweiterung steht ab heute auf GitHub zum Download bereit.

*Auszug Pressemitteilung