Das Jahr 2024 markiert einen bedeutenden Fortschritt in der KI-Entwicklung. Die schnellen Fortschritte in der Künstlichen Intelligenz (KI), insbesondere auch bei großen Sprachmodellen (LLMs) sind herausragend. Was ist erforderlich, um diese Technologien selbst zu nutzen?

Lokale Hardware vs. Cloud-Dienste

Bei der Entscheidung zwischen dem Kauf von Hardware wie einer NVIDIA RTX 4090 oder der Nutzung von Cloud-Diensten gibt es mehrere Faktoren zu berücksichtigen.

Die Kontrolle über die eigenen Daten ist ein wichtiger Faktor. Während Cloud- und APP-Anbieter wie OpenAI und Google Cloud Datenschutz- und Sicherheitsgarantien bieten, bleibt das Vertrauen ein entscheidender Punkt. Das lokale Betreiben von Modellen auf eigener Hardware bietet die größte Sicherheit, da keine sensiblen Daten an externe Server übertragen werden. Unternehmen wie Samsung haben die Nutzung von KI-APIs aufgrund von Datenschutzbedenken bereits eingeschränkt.

Die Kosten für den Betrieb von KI-Modellen variieren stark zwischen lokaler Hardware und Cloud-Diensten. Eine NVIDIA RTX 4090 bietet erhebliche Rechenleistung für ein breites Spektrum an Aufgaben, von Bildgenerierung bis zur Textverarbeitung. Der einmalige Kauf und die laufenden Betriebskosten können jedoch erheblich sein. Ein System mit einer RTX 4090 kostet etwa 2.200 USD.

Cloud-Dienste wie AWS oder Microsoft Azure bieten flexible und skalierbare Lösungen. Die Nutzungskosten für eine V100-GPU-Instanz bei AWS betragen etwa 2,311.20 USD pro Jahr bei 15% Auslastung. Für kurzfristige Projekte oder variable Nutzungen sind Cloud-Dienste oft günstiger und flexibler.

Entscheidungshilfen für die Wahl der KI-Hardware

Egal ob Hard- oder Software: Bei allen IT Fragen ist man gut beraten, sich auf dem Laufenden zu halten und zur Entscheidungsfindung Expertenratschläge zu würdigen. Während Hardware-Tests und Vergleiche entscheidend sind, ist es ebenso wichtig, sich im Web über aktuelle IT- und Technologietrends im Allgemeinen zu informieren.

Techopedia ist eine dieser Informationsquellen im Internet, die Seite vergleicht nicht nur Spiele und stellt Anbieter vor und gibt eine Topauswahl, sondern versteht sich als Anlaufstelle für professionelles IT-Fachwissen und Inspiration und ist bestrebt eine vertrauenswürdige Quelle für durchdachte Inhalte zu sein, um über die Technologien zu informieren, die den Markt beeinflussen. Wer gut informiert ist, dem fallen Entscheidungen deutlich leichter.

Bezüglich der KI Anwendung sollte man folgende Punkte berücksichtigen:

- Datenschutzfokus

Wenn höchste Sicherheit und Datenschutz erforderlich sind, ist die lokale Hardware oder die Nutzung von Cloud-VMs vorzuziehen. Hierbei bleiben alle Daten in der eigenen Kontrolle, ohne dass sie an externe Anbieter übermittelt werden.

- Experimentieren und Forschung

Für das Experimentieren und die Erforschung neuer KI-Modelle eignen sich zunächst APIs von High-End-Anbietern wie ChatGPT und Claude. Dies ermöglicht eine schnelle und kosteneffiziente Prüfung der Machbarkeit, bevor eventuell in lokale Hardware investiert wird.

- Langfristige Nutzung und Feinabstimmung

Für langfristige Projekte oder umfangreiche Feinabstimmungen kann die Investition in lokale Hardware sinnvoll sein. Insbesondere wenn die Nutzung über 300 Tage pro Jahr hinausgeht, erweist sich der Kauf einer leistungsfähigen GPU als kosteneffizienter.

- Wirtschaftliche Überlegungen

Ein detaillierter Kostenvergleich zeigt, dass die Desktop-GPU bei intensiver Nutzung günstiger ist. Die anfänglichen Anschaffungskosten und die laufenden Betriebskosten übersteigen oft die flexiblen und skalierbaren Kosten von Cloud-Diensten nur bei intensiver und langfristiger Nutzung.

Es zeigt sich, dass leistungsstarke GPUs wie die RTX 4090 erhebliche Vorteile für die lokale Verarbeitung von KI-Modellen bieten. Diese Hardware ermöglicht niedrige Latenzzeiten und hohe Bildraten, was besonders für Anwendungen wie Gaming oder Echtzeit-Videoverarbeitung wichtig ist. Zudem bieten sie erhebliche Vorteile bei der Trainingszeit von Modellen.

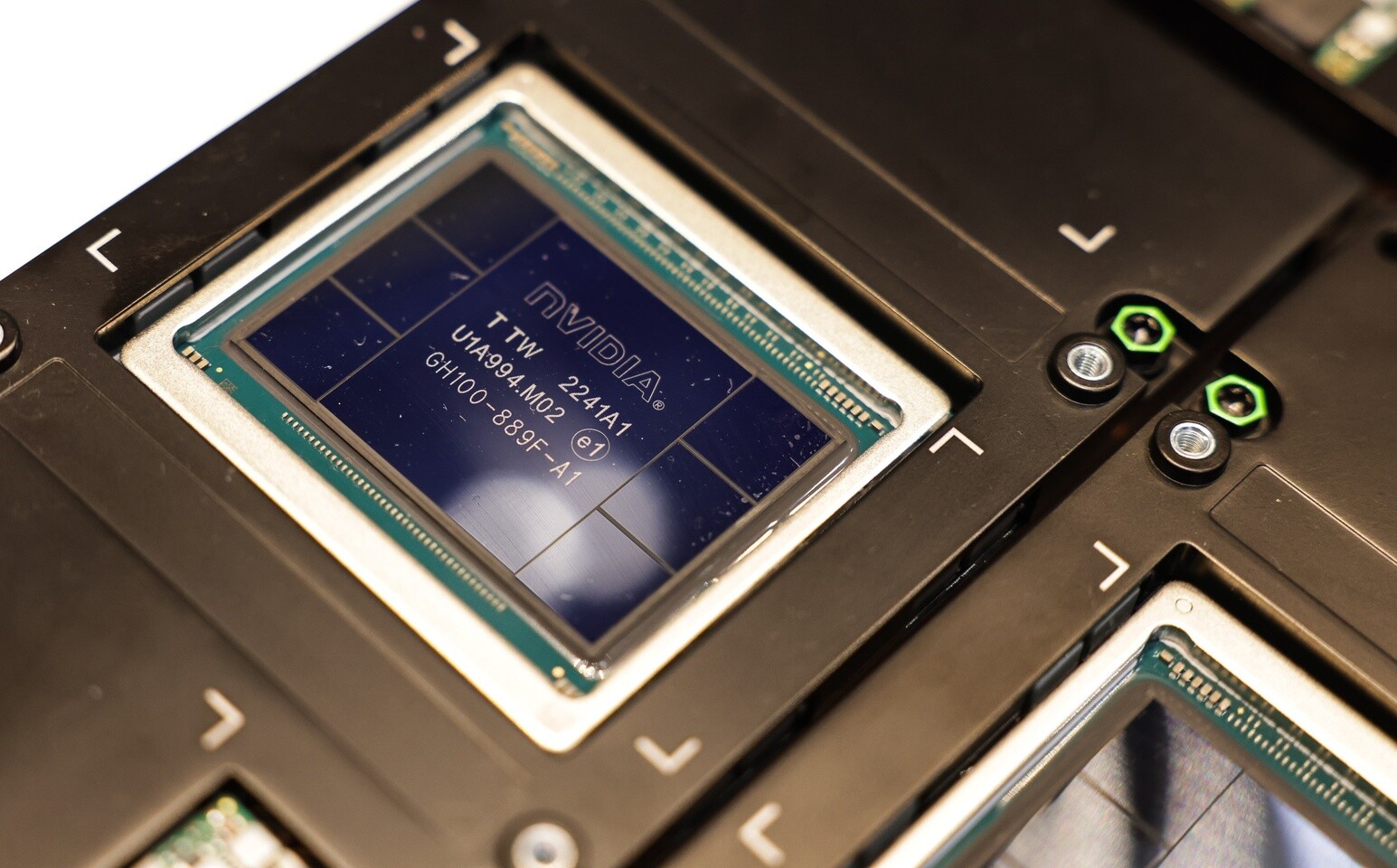

Cloud-Lösungen hingegen bieten Zugriff auf fortschrittliche Hardware wie A100s und H100s, die für spezifische Hochleistungsanwendungen optimiert sind. Diese bieten Funktionen, die in Consumer-GPUs nicht verfügbar sind, und eignen sich besonders für umfangreiche und spezialisierte KI-Projekte.

Fazit

Die Wahl zwischen lokaler Hardware und Cloud-Diensten hängt stark von den spezifischen Anforderungen und der geplanten Nutzung ab. Für höchste Sicherheit und langfristige Projekte ist lokale Hardware oft die bessere Wahl. Für flexible und kurzfristige Anforderungen bieten Cloud-Dienste eine kosteneffiziente und skalierbare Lösung. Letztendlich ist eine sorgfältige Analyse der individuellen Bedürfnisse und der verfügbaren Optionen entscheidend für die optimale Wahl der KI-Hardware.